Roboter stechen besser als Ärzte

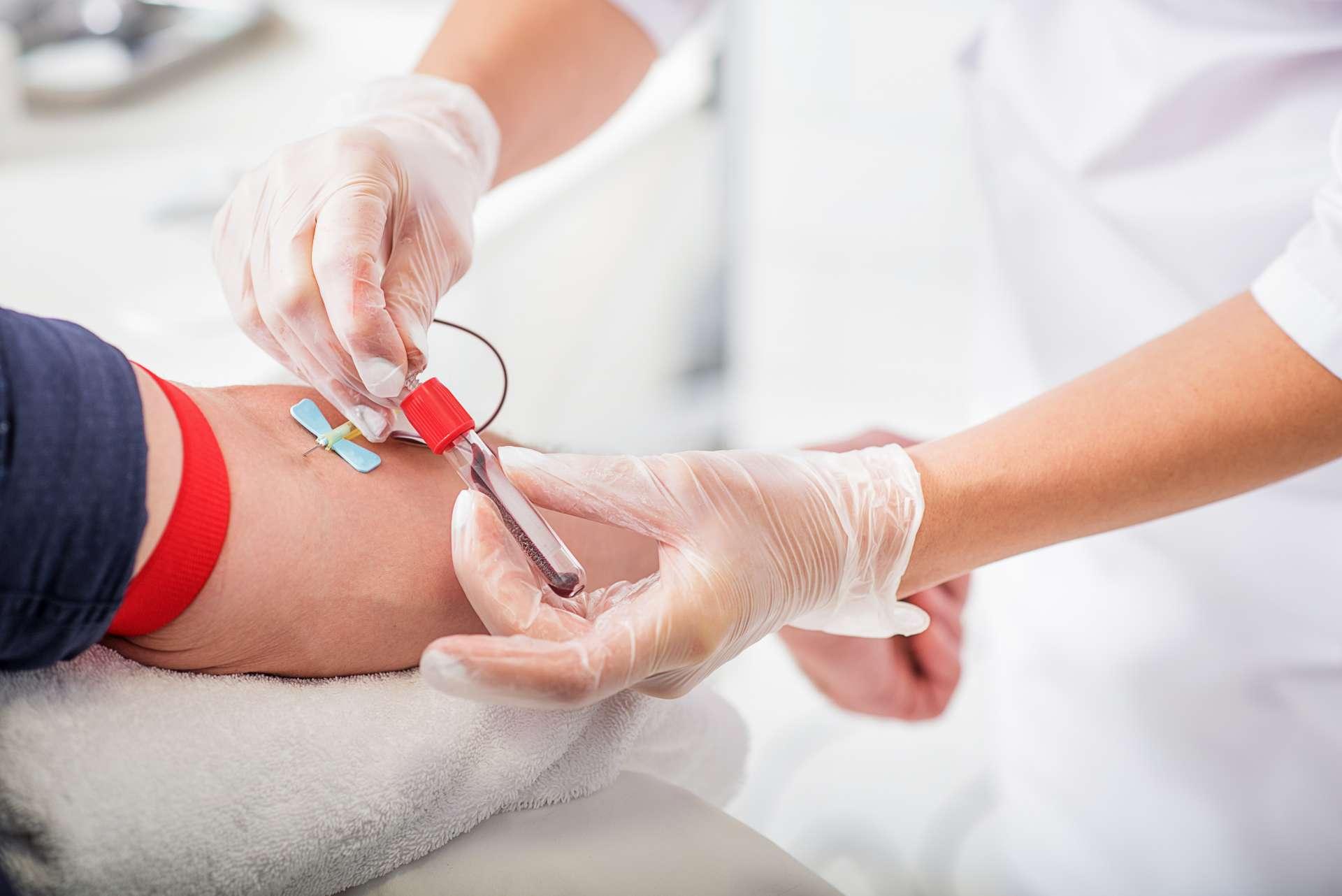

Ein Roboter mit künstlicher Intelligenz (KI), der besser als ein Arzt Blutabnehmen kann, ist keine Science-Fiction, sondern bereits möglich – dank Nahinfrarot-Kamera, Ultraschall und Deep-Learning.

Statistisch gesehen geht jeder fünfte Stich beim Blutabnehmen daneben. Bei Patienten mit besonders «schlechten» Venen beträgt die Negativquote sogar über 50 %. Oft sind mehr als fünf Versuche notwendig, bis es klappt.

Maschinen besitzen inzwischen Fähigkeiten, die ihnen erlauben, Menschen auch autonom zu behandeln, z.B. in der endovaskulären Therapie. Dass dies auch fürs Blutabnehmen gilt, bewiesen US-amerikanische Wissenschaftler.

Sie entwickelten eine mobile, etwa staubsaugergrosse Maschine, in die der Patient seinen Arm hineinlegt. Mit Nahinfrarot- und Ultraschall-Technologie tastet der Roboter den Arm der Person ab. Seine künstliche Intelligenz hat gelernt, die Tiefe, Bewegung und Art der vorhandenen Strukturen zu erfassen und sich geeignete Gefässe auszusuchen.

Medizinern mehr Zeit für anderes geben

Zuvor war es beim Punktieren von Modellen und Rattenvenen dem Apparat gelungen, die Rate der Fehlversuche im Vergleich zum Arzt auf einen Sechstel zu reduzieren und die Trefferquote auf 53 % bis 88 % anzuheben. Ganz besonders stach er die Konkurrenz aus, wenn schwierige anatomische Verhältnisse wie Gefässe < 1 mm vorlagen.

«Die Sicherheit bleibt natürlich stets ein kritischer Aspekt bei solchen Maschinen», räumen die Autoren ein. Deshalb haben sie ihrem Roboter beigebracht, auf jede Bewegung des Arms und plötzliche Veränderung des Widerstands, auf den die Nadel trifft, sofort zu reagieren. Zudem hat ihr Apparat schnell gelernt, nicht auf die falschen Strukturen zu zielen.

Die Forscher haben bei ihrer Entwicklung u.a. an Notfallsituationen gedacht, in denen eine schnell und sicher platzierte Kanüle Leben retten kann. Wenn sich der Roboter tatsächlich auch im klinischen Alltag bewähre, schreiben sie, könnte er den Ärzten Freiräume für andere Tätigkeiten verschaffen.

Chen A et al.

Nat Mach Intell 2020; 2: 104–115.